Design sells a promise, but the real challenge in the process of design is ensuring that the design’s promise fits the user’s expectations. This is especially true if we talk about products for everyday use. The Experience Design Team at Whirlpool México took the challenge and developed a methodology that is helping the company to understand and measure users’ perceptions of design.

One of our first approaches to understanding users’ perceptions consisted of using semantic cards. Even though this kind of evaluation has worked well in some countries, we found that Mexican participants had difficulty assigning semantic values to products. People tended to distort the meaning of the adjectives used to evaluate design. We also needed a larger sample size and to customize evaluations (according to user target) in order to have trusted results, making the process long lasting and expensive.

We then decided to change to a different approach that better suited Latin America and turned to a methodology already tested in Whirlpool Europe: SEQUAM (Sensorial Quality Assessment Method), developed by Lina Bonapace and Luigi Bandini-Buti at their ergonomics studio in Milan. This approach involves analyzing a product or prototype in terms of the formal properties of its aesthetic elements and then, through empirical studies and structured interviews, linking these properties with product benefits (Bonapace 1999). The basic methodology has three main phases of evaluation:

- Visual

- Tactile

- Use

SEQUAM used a sample of 20 people with individual interviews lasting about two hours, making the overall duration of the test about a week. Even though the information from the test included analysis of rankings and ratings, the core deliverable was the qualitative feedback obtained from users. We wanted perceptions of design, but there was some reluctance to accept the SEQUAM results, as they contained too much qualitative data rather than statistical analysis. In looking at the data, we noticed that it was very difficult to uncover what users meant by the “best quality design.” For example, when faced with a choice of coffee makers, some participants used words to justify their choice like “ease of usse,” while others talked about “durability of materials” or “best performance.” When we started analyzing this behavior, we detected that verbalized perceptions typically corresponded to experience values rather than aesthetic values. That meant users tended to justify what they liked extrinsically (aesthetics) with intrinsic values (those related to the experience of use).

Developing a New Method

After some years of experience using SEQUAM, we saw an opportunity to measure more specifically the experience values of design as perceived by users, while at the same time improving the methodology with scientific rigor demanded by company management.

Our first step was to identify the core experience values associated with the design of household appliances. We found and categorized several values associated with household appliances according main platforms (cooking, laundry and food preservation) We can illustrate them with those that could apply to a small category of household appliances like portables (e.g. coffee makers or toasters):

- Usability

- Maintainability

- Portability

- Capacity

Identifying these values was the first step in a deeper understanding of user perceptions. Measuring these values helped us to set targets by brand and product. This was especially useful because Mexico has a wide range of users and products that go from low-end to high-end, and from mass market to premium brands.

Experience values would represent the backbone of an evaluation of design perceptions, but we also wanted to look at the possibility of assessing extrinsic values like modernity, technology, surprise, uniqueness, craftsmanship, and so on.

As a second step towards the new methodology, we decided to use an approach similar to SEQUAM, with in-depth user research. The study would simulate user behavior on the sales floor with people seeing our products among their main competitors. This study included three phases:

- Visual phase captured as First Impact perceptions

- Tactile phase captured as a Non-Guided Exploration of products

- Use phase, captured as a Guided Exploration of features among the products by a third part

To add scientific rigor to the methodology, we decided to increase the sample size to 30 people; this number would allow us to create average scores that could be submitted to Analysis of Variance (ANOVA) testing. Further analysis would give us the opportunity to validate and identify differences among means of scores as part of random error or because significant variance with a confidence level of 95% or up to 99%. We also thought that reporting results would highlight scores rather than rankings; rankings would require a larger sample size to validate statistic accuracy, while mean scores would allow us to determine its accuracy (or variance) by use of experimental analysis.

One of the radical changes from SEQUAM was conducting the test with groups of participants instead of individual sessions. To solve the problems of data bias, we followed these actions:

- Brands and machine capacity claims for products would be hidden.

- Participants were asked to follow three basic rules: be honest; neither influence nor get influenced by others; and be fun.

- Participants would record their scores individually using a printed guide with a continuum scales and a clipboard.

- Small focus groups would capture qualitative feedback during the non-guided exploration phase.

- Three note takers would assist with recording individual feedback from the guided exploration phase.

The use of groups in evaluation allowed us to reduce the time and cost, and enabled us to focus on a detailed analysis of information, including both the statistics and qualitative comments of users.

Because the test had changed enough that it was no longer a SEQUAM, we decided to call it PQ (Perceived Quality) test.

Case Study: Identifying key attributes in countertop appliances

The design of countertop appliances is a good example on which PQ test could deliver valuable information to identify, measure and drive the design of new elements.

When thinking about a blender, the key elements users pay attention to are overall size, capacity and material of glass, and speed control. These elements are translated to:

- Portability

- Capacity

- Maintainability

- Robustness

- Usability

The assessment of key attributes is made after introduction of test and allows users set a mindset in context.

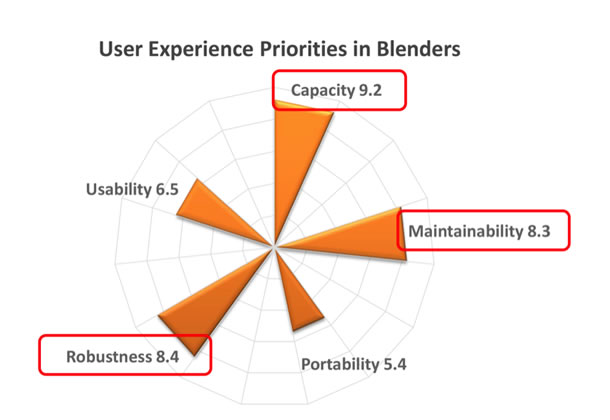

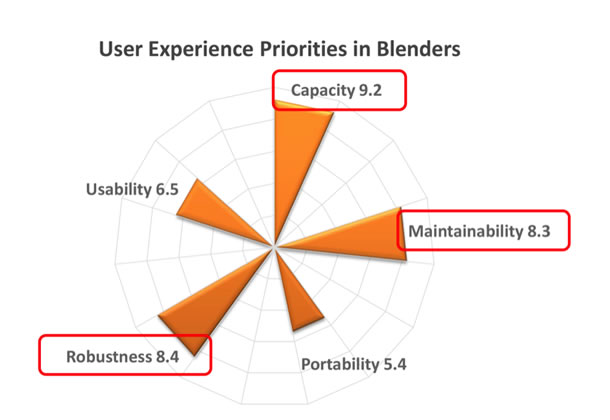

The first data obtained in our test showed where the users’ priorities were when looking at a blender. Figure 1 shows a radar chart depicting a mean of scores obtained from analysis. The chart shows that users pay great attention on capacity of glass but at same time demand good cleanability of product. Robustness follows the importance according users’ priorities while usability and portability recorded lowest values. This doesn’t mean that users don’t care about usability or portability but these two attributes are maybe taken for granted among existing products.

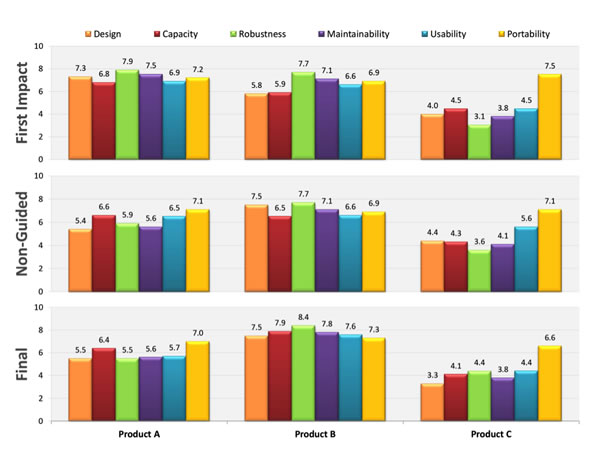

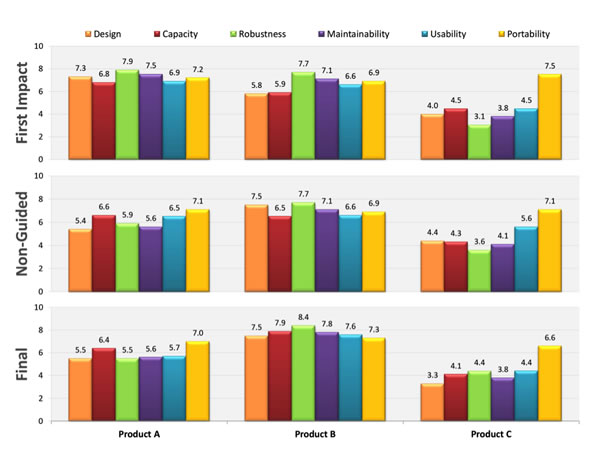

First Impact stage captured user’s perceptions among key identified attributes. Users immediately translated experience expectations on design demands. Figure 2, shows better perceptions on Product A due great capacity and speed controls. Product B, perceived a slightly smaller than product A, but competitive among rest of attributes. On the other hand product C captured low scores due its evident small size but rated good in portability.

Table 1. Scores of the first Impact Perceptions

| Product | A | B | C |

|---|---|---|---|

| Design | 7.3 | 5.8 | 4.0 |

| Capacity | 6.8 | 5.9 | 4.5 |

| Robustness | 7.9 | 7.7 | 3.1 |

| Maintainability | 7.5 | 7.1 | 3.8 |

| Usability | 6.9 | 6.6 | 4.5 |

| Portability | 7.2 | 6.9 | 7.5 |

Non-Guided Exploration uncovers users expectations on products attributes. In this case study, Product A, considered best in first impact, falls in perceptions mainly due to the material the jar is made of (polycarbonate, seemingly not noticed at first) while product B, second in first stage, moves to best perception scores. With its real glass of jar, it was now the unit people “liked” most, as reflected in the design ratings. This change of perception was clearly verbalized among all groups by the time they reviewed the jars, pointing out promptly to “plastic” as material that keeps odors in contrast with glass that is easier to clean and odorless. Product C remained out of best scores of perceptions due the small capacity but still good in good portability.

Table 2. Scores of the Non-Guided Exploring Perceptions

| Product | A | B | C |

|---|---|---|---|

| Design | 5.4 | 7.5 | 4.4 |

| Capacity | 6.6 | 6.5 | 4.3 |

| Robustness | 5.9 | 7.7 | 3.6 |

| Maintainability | 5.6 | 7.1 | 4.1 |

| Usability | 6.5 | 6.6 | 5.6 |

| Portability | 7.1 | 6.9 | 7.1 |

During the final Guided Exploration phase, the test moderator guided participants to review and assess specific parts and features. This exploration included most of the physical features: Case, Controls, Blades, Jar and Lid. This stage does not generally dramatically change the perception of experience values among users, nonetheless it allows researchers to uncover details that lead to better perceptions. This is illustrated well by the way people point out features like the capacity of jar, or the ability to remove blades for better cleanability. This last feature is greatly valuable in Mexico, where consumers are used to having to disassemble everything for deep cleaning.

The test concluded by asking participants to assess their overall perceptions of the products. This assessment represented the final feeling of the users after a deep process of interaction with the products. We used this final evaluation to report how users evolved in their perceptions through each stage of the interaction process of the test (visual-touching-exploring). This evolution is reported in a slide that summarizes the perception of users throughout the test (see Figure 4), showing ratings that improved or dropped.

Table 3. Scores from the final assessment

| Product | A | B | C |

|---|---|---|---|

| Design | 5.5 | 7.5 | 3.3 |

| Capacity | 6.4 | 7.9 | 4.1 |

| Robustness | 5.5 | 8.4 | 4.4 |

| Maintainability | 5.6 | 7.8 | 3.8 |

| Usability | 5.7 | 7.6 | 4.4 |

| Portability | 7.0 | 7.3 | 6.6 |

Conclusions

The measurement of perceptions has represented a difficult challenge in user experience. We are fully aware that users build their deeply subjective perceptions through long experience, and that these perceptions are very hard to rate and verbalize. Our approach is not a panacea that can undercover what happens in the mind of users during every day of use, but this methodology has worked well by informing key aspects of design that need special attention to fulfill user expectations.

Our use of the PQ test still raises some concerns within the company. During a global meeting with UX leaders, some questioned whether there are too many parameters included for typical users, or if the way we correlate qualitative information with ratings of perception is correct. Every time we prepare a PQ test, I explain that it is an experimental analysis. We need more than one interaction with users to undercover correlations of perceptions to key elements of a design.

As part our best practices, we continually look for ways to improve our own methodology. The PQ test has proved to be both effective and efficient in driving good design decisions, but still needs to evolve through experience. Our responsibility is to be there to supply the best user experience, and the best experience starts with good perceptions.

那些试图量化用户感觉的用户体验从业者应当考虑采用感知质量测试方法。用户通过长期体验形成了自己对产品的看法,具有很强的主观性,但是往往发现很难用语言表达出来。本文将介绍惠尔普如何采用感知质量测试方法在墨西哥市场进行关于消费者使用洗衣机行为和态度的一项调查。

사용자 인식을 정성적으로 분석하고자 하는 UX 실천가들은 인식된 품질 테스트를 고려해야 합니다. 사용자들은 오랜 기간 경험을 통해 상품에 대한 인식을 매우 주관적으로 쌓습니다. 하지만 어떤 인식을 했는지 말로 표현하기는 어려운 경우가 많습니다. 이 기사는 멕시코 시장에서 소비자들이 세탁기에 대해 취하는 행동 및 태도에 관한 월풀의 연구에서 PQ 테스트의 사용을 검토함으로써 PQ 테스트가 어떻게 활용될 수 있는지를 보여줍니다.

Os praticantes da experiência do usuário que buscam qualificar a percepção do usuário devem considerar o Teste de Percepção de Qualidade. Os usuários criam suas percepções de produtos por meio de longa experiência e com profunda subjetividade, mas sempre encontram dificuldade em verbalizá-las. Este artigo ilustra como o teste de PQ pode ser alavancado por meio de análise de seu uso em um estudo da Whirlpool sobre comportamentos e atitudes de consumidor sobre máquinas de lavar no mercado mexicano.

O artigo completo está disponível somente em inglês.

ユーザーの知覚を定量化したいUX専門家なら、知覚品質テストの実施を検討すべきであろう。ユーザーは、長期間にわたる経験と深い主観性を通じて製品に対する知覚を構築するが、それを言葉で表現するのは困難な場合が多い。本稿では、メキシコ市場で実施したWhirlpool社の洗濯機に対する消費者の行動と態度に関する研究における、知覚品質テストの利用の検証から、同テストはどのように活用することができるかを説明する。

El diseño vende una promesa, pero el desafío real en el proceso de diseño es asegurar que esa promesa de diseño cumpla las expectativas de los usuarios. Esto es especialmente verdadero cuando hablamos de productos de uso diario. El equipo de Experiencia de Diseño en Whirlpool México tomó el desafío y desarrolló una metodología que está ayudando a la compañía a entender y medir las percepciones de los usuarios sobre el diseño.

Una de nuestras primeras aproximaciones consistió en usar tarjetas semánticas. Aún cuando este tipo de evaluaciones ha funcionado bien en algunos países, descubrimos que los participantes mexicanos tenían dificultades al asignar valores semánticos a los productos. La gente tiende a distorsionar el significado de los adjetivos usados al evaluar el diseño. Queríamos una muestra más grande y personalizar las evaluaciones (de acuerdo al usuario objetivo) de manera de poder obtener resultados confiables, hacienda que el proceso fuera duradero y caro.

Decidimos tomar un enfoque diferente que fuera más acorde a la realidad latinoamericana y virara más hacia una metodología que había sido ya probada en Whirlpool Europa: SEQUAM (Sensorial Quality Assessment Method, Método de Evaluación de la Calidad Sensorial), desarrollado por Lina Bonapace y Luigi Bandini-Buti en su estudio sobre Ergonomía en Milán. Este enfoque implica analizar un producto o prototipo en términos de las propiedades formales de sus elementos estéticos para luego, a través de estudios empíricos y entrevistas estructuradas, vincular esas propiedades con los beneficios del producto (Bonapace 1999). Esta metodología tiene tres fases principales de evaluación:

- Visual

- Táctil

- Uso

SEQUAM usaba una muestra de 20 personas con entrevistas individuales de alrededor de dos horas, haciendo que todo el proceso de la prueba durara alrededor de una semana. A pesar de que la información de la prueba incluía el análisis de rankings y clasificaciones, el elemento central resultante era la retroalimentación cualitativa de los usuarios. Queríamos percepciones de diseño, pero había un poco de reticencia a aceptar los resultados de SEQUAM pues contenían demasiados datos cualitativos en vez de análisis estadístico. Al mirar los datos, nos dimos cuenta que era muy difícil saber qué querían decir los usuarios al hablar del “mejor diseño”. Por ejemplo, cuando debían escoger lavadoras, algunos participantes usaban palabras para justificar sus elecciones como “gran capacidad”, mientras otros hablaban de la “durabilidad de los materiales” o el “mejor desempeño”. Cuando comenzamos a analizar este comportamiento, nos dimos cuenta que las percepciones verbalizadas típicamente corresponden a valores de la experiencia más que a valores estéticos. Eso significaba que los usuarios tenían a justificar lo que les gustaba extrínsicamente (estética) con los valores intrínsecos (los que se relacionan a la experiencia de uso).

Desarrollando un Nuevo Método

Después de usar SEQUAM algunos años, vimos la oportunidad de medir más específicamente como los usuarios percibían los valores de la experiencia del diseño, y al mismo tiempo, la gerencia de la compañía nos pidió mejorar la metodología con rigor científico.

Nuestro primer paso fue identificar los valores centrales de la experiencia al diseñar artefactos para el hogar. Encontramos y categorizamos varios valores asociados con los artefactos domésticos en las principales plataformas (cocina, lavado y cuidado de los alimentos). Podemos ilustrarlos con aquellos que se relacionan a los artefactos más pequeños como los portables (por ejemplo, cafeteras o tostadoras):

- Usabilidad

- Mantención

- Portabilidad

- Capacidad

Identificar estos valores fue el primer paso en profundizar el entendimiento de las percepciones de los usuarios. Medir estos valores nos ayudó a establecer objetivos por marca y producto. Esto fue especialmente útil porque en México hay una gama muy amplia de usuarios y productos que van desde los más bajos a los más altos, y desde marcas masivas a marcas exclusivas.

Los valores de la experiencia representarían la columna vertebral de la evaluación de las percepciones de diseño, pero también queríamos mirar la posibilidad de evaluar valores extrínsecos como la modernidad, tecnología, sorpresa, originalidad, artesanía y así sucesivamente.

Como segundo paso hacia la nueva metodología, decidimos usar un enfoque similar al SEQUAM, con investigación de usuarios en profundidad. Esta vez, sin embargo, el estudio sería conducido en el piso de venta con la gente viendo nuestros productos en conjunto con los de la competencia. Este estudio incluyó tres fases:

- Fase Visual capturada como percepciones de Primer Impacto

- Fase Táctil capturada como una Exploración No Guiada de productos

- Fase de Uso, capturada como una Exploración Guiada de un tercero sobre las características de los productos

Para añadir rigor científico a la metodología, decidimos aumentar la muestra a 30 personas; este número nos permitiría crear puntajes promedio que podrían ser enviados a las pruebas de Análisis de Varianza (Analysis of Variance, ANOVA, por sus siglas en inglés). Un análisis posterior nos daría la oportunidad de validar e identificar las diferencias entre medias de puntajes como parte de un error o porque había una varianza significativa en el nivel de confianza entre 95 y 99%. También pensamos que estos resultados resaltarían puntajes más que clasificaciones; ya que las clasificaciones necesitan una muestra más grande para poder validar la exactitud de las estadísticas, mientras que puntajes promedio nos permitirán determinar la exactitud (o varianza) con el uso de un análisis experimental.

Uno de los cambios radicales de SEQUAM fue conducir el test con grupos de participantes en vez de sesiones individuales. Para resolver los problemas de datos tendenciosos, seguimos las siguientes acciones:

- Las marcas y las capacidades de las máquinas estarían escondidas

- Se les pidió a los participantes seguir 3 reglas básicas: ser honestos; no ser influenciados o influenciar a otros; y ser entretenidos.

- Los participantes grabarían sus puntajes individualmente usando una guía impresa con escalas de continuo y un archivador.

- Se harían pequeños grupos de discusión para capturar retroalimentación cualitativa durante la fase de exploración no guiada.

- Tres personas tomarían notas con la retroalimentación individual en la fase de exploración guiada.

El uso de grupos en la evaluación nos permitió reducir tiempo y costos y enfocarnos en el análisis detallado de la información, incluyendo tanto las estadísticas como los comentarios cualitativos de los usuarios.

Debido a que la prueba había cambiado tanto ya no era SEQUAM, por lo que decidimos nombrarla prueba de Calidad Percibida o PQ (Perceived Quality, por sus siglas en inglés).

Caso de Estudio: Identificar atributos clave en artefactos de mesa

El diseño de artefactos de mesa es un buen ejemplo con el que la prueba de Calidad Percibida (PQ) puede entregar información valiosa para identificar, medir y conducir nuevos elementos en el diseño.

Cuando pensamos en una juguera, los elementos clave en que los usuarios enfocan su atención son el tamaño, la capacidad y el material del vidrio, y el control de la velocidad. Estos elementos se traducen en:

- Portabilidad

- Capacidad

- Mantención

- Robustez

- Usabilidad

La introducción a los atributos clave fue hecha tras anunciarle a los usuarios la prueba y permitirles establecer un modelo mental del contexto.

La primera data obtenida en nuestra prueba mostró que las prioridades de los usuarios al mirar a una licuadora. La Figura 1 muestra un gráfico de radar con el promedio de los puntajes obtenidos del análisis. El gráfico muestra que los usuarios prestaron gran atención a la capacidad del vaso, pero, a la vez, pidieron buena limpieza del producto. La robustez sigue en importancia, mientras que la usabilidad y la portabilidad reflejaron valores menores en las prioridades de los usuarios. Esto no significa que los usuarios no se preocupen de la usabilidad o portabilidad, sino que estos dos atributos quizás eran considerados como obvios para los productos existentes.

La etapa de Primer Impacto capturó las percepciones de los usuarios en los atributos clave identificados. Los usuarios inmediatamente tradujeron las expectativas de su experiencia en demandas de diseño. La Figura 2 muestra mejores percepciones en el Producto A dado que tenía más capacidad and controles de velocidad. El Producto B fue percibido como más pequeño que el producto A, pero competitivo en el resto de los atributos. El producto C capturó menos puntaje dado que su tamaño era más pequeño, pero rankeó bien en portabilidad.

Tabla 1. Puntajes de las Percepciones de Primer Impacto

| Producto | A | B | C |

|---|---|---|---|

| Diseño | 7.3 | 5.8 | 4.0 |

| Capacidad | 6.8 | 5.9 | 4.5 |

| Robustez | 7.9 | 7.7 | 3.1 |

| Mantención | 7.5 | 7.1 | 3.8 |

| Usabilidad | 6.9 | 6.6 | 4.5 |

| Portabilidad | 7.2 | 6.9 | 7.5 |

La Fase de Exploración No Guiada descubre las expectativas de los usuarios en los atributos de los productos. En este caso de estudio, el Producto A fue considerado mejor en el primer impacto, resultando en una falla en las percepciones debido a que el vaso está hecho de policarbonato (que al parecer no salta a la vista en una primera mirada), mientras que el producto B , segundo en la primera fase, mostró mejores puntajes de percepción. Con el vaso real de vidrio, fue la unidad que más le gustó a la gente, lo que se reflejó en los puntajes de diseño. Este cambio en la percepción fue claramente verbalizado entre todos los grupos en el momento en que revisaron los vasos, destacando que el plástico era el material que mantenía los olores en contraste con el vidrio que era más fácil de limpiar y no mantener olores. El Producto C se mantuvo con los mejores puntajes de percepciones debido a su pequeña capacidad, pero buena portabilidad.

Tabla 2. Puntajes de las Percepciones de la Fase de Exploración No Guiada

| Producto | A | B | C |

|---|---|---|---|

| Diseño | 5.4 | 7.5 | 4.4 |

| Capacidad | 6.6 | 6.5 | 4.3 |

| Robustez | 5.9 | 7.7 | 3.6 |

| Mantención | 5.6 | 7.1 | 4.1 |

| Usabilidad | 6.5 | 6.6 | 5.6 |

| Portabilidad | 7.1 | 6.9 | 7.1 |

Durante la fase Final de Exploración Guiada, el moderador de la prueba guió a los participantes para que pudieran revisar partes y características específicas. Esta exploración incluyó la mayoría de las características físicas: Caja, Controles, Cuchillas, Vaso y Tapa. Esta etapa no cambia dramáticamente la percepción de los valores de la experiencia en los usuarios, sin embargo le permite a los investigadores descifrar detalles que los llevan a mejores percepciones. Esto se ilustra bien por la manera en que las personas destacan las características como la capacidad del vaso o la habilidad de sacar las cuchillas de la juguera para poder limpiarla mejor. Esta última característica fue de gran valor para los mexicanos, quienes están acostumbrados a desarmar todo para realizar limpiezas profundas.

La prueba terminó pidiéndole a los participantes que dieran sus impresiones generales de los productos. Estas percepciones representaban el sentimiento final de los usuarios después de un profundo proceso de interacción con los productos. Usamos esta evaluación final para investigar cómo cambiaban las percepciones de los usuarios en cada fase de los procesos de interacción de la prueba (visual-táctil-exploratorio). Esta evolución es resumida en una diapositiva donde se ven las percepciones de los usuarios en la prueba (ver Figura 4), a través de puntajes que aumentaron o disminuyeron.

Tabla 3. Puntajes de la última revisión

| Producto | A | B | C |

|---|---|---|---|

| Diseño | 5.5 | 7.5 | 3.3 |

| Capacidad | 6.4 | 7.9 | 4.1 |

| Robustez | 5.5 | 8.4 | 4.4 |

| Mantención | 5.6 | 7.8 | 3.8 |

| Usabilidad | 5.7 | 7.6 | 4.4 |

| Portabilidad | 7.0 | 7.3 | 6.6 |

Conclusiones

La medición de las percepciones ha sido un desafío difícil en la experiencia de usuario. Estamos plenamente conscientes de que los usuarios construyen sus percepciones subjetivas a través de una larga experiencia, y que esas percepciones son muy difíciles de evaluar y verbalizar. Nuestro enfoque no es la panacea que permitirá descifrar qué pasa en la mente de los usuarios durante cada día de uso, pero esta metodología ha funcionado bien al dar cuenta de los aspectos claves del diseño que necesitan atención especial para cumplir las expectativas de los usuarios.

Nuestro uso de la prueba PQ aún plantea dudas en nuestra compañía. Durante una reunión con líderes de Experiencia de Usuario alrededor del mundo, algunos cuestionaron si es que habían demasiados parámetros incluidos para los usuarios típicos, o si la manera en que correlacionábamos la información cualitativa era la correcta. Cada vez que preparamos una prueba PQ, yo explico que es un análisis experimental. Necesitamos más que una interacción con los usuarios para descubrir correlaciones entre las percepciones y los elementos claves de diseño.

Como parte de nuestras mejores prácticas, seguimos buscando maneras de mejorar nuestra metodología. La prueba PQ ha probado ser tanto efectiva como eficiente en ayudar a tomar mejores decisiones de diseño, pero aún necesita evolucionar a través de la experiencia. Nuestra responsabilidad es estar ahí para entregar la mejor experiencia de usuario, y la mejor experiencia comienza con buenas percepciones.